生成AI活用に求められる「アジャイル・ガバナンス」の重要性 【弁護士/スマートガバナンス 代表取締役共同創業者 落合 孝文氏】 【弁護士/スマートガバナンス 代表取締役CEO 羽深 宏樹氏】

Chat GPT の登場をはじめ、日進月歩で進化を遂げる「生成AI」。インターネットやスマートフォンが社会を変革したように、生成AIも過去に匹敵するパラダイムシフトを起こし 、広告やマーケティングにも大きな影響を与えると言われています。生成AIはビジネスをどのように変革し、新たな社会を切り拓いていくのか。

博報堂DYホールディングスは生成AIがもたらす変化の見立てを、「AI の変化」、「産業・経済の変化」、「人間・社会の変化」 の3つのテーマに分類。各専門分野に精通した有識者との対談を通して、生成AIの可能性や未来を探求していく連載企画をお送りします。

第7回は「AIガバナンス」をテーマに、今後生成AIを活用するうえで求められるガバナンスや仕組みづくりで注意すべき点について、渥美坂井法律事務所・外国法共同事業 弁護士の落合 孝文氏、スマートガバナンス株式会社 代表取締役CEO・弁護士の羽深 宏樹氏のお二人に、生成AIも含めた先進技術普及における社会的枠組みの整備・事業活用に多くの知見を持つクロサカ タツヤ氏とともに、博報堂DYホールディングスの西村が話を伺いました。

連載一覧はこちら

(写真右から)

クロサカ タツヤ氏

慶應義塾大学大学院政策・メディア研究科 特任准教授

株式会社 企(くわだて) 代表取締役

羽深 宏樹氏

スマートガバナンス株式会社 代表取締役CEO

京都大学大学院法学研究科特任教授・弁護士

落合 孝文氏

渥美坂井法律事務所・外国法共同事業 シニアパートナー弁護士

プロトタイプ政策研究所 所長

スマートガバナンス株式会社代表取締役共同創業者

西村 啓太

博報堂DYホールディングス

マーケティング・テクノロジー・センター 室長代理

株式会社Data EX Platform 取締役COO

生成AIの“無限定”性がもたらす2つのリスク

- 西村

- 今回は、イノベーションの社会実装に向けたガバナンスのコンサルティング等を行うスマートガバナンスの代表であり弁護士である羽深さんと落合さんに、「AIガバナンス」をテーマにお話を伺えればと思います。お二人は、それぞれ経産省と総務省で、「AI事業者ガイドライン」策定のワーキンググループのメンバーも務められています。まずは行政、企業などさまざまな主体が生成AIを活用していく際に想定される懸念やリスクについて、お二人の意見をお聞かせください。

- 羽深

- 生成AIは、従来型のAIのようにディープラーニング技術をベースにしていますが、リスクの観点からは異なる部分もあります。大きく違う点としてまず一つ目は、「使用目的が無限定であること」です。これまでのAIも、「予測不可能性」や「説明不可能性」などガバナンス上の問題点が指摘されてきましたが、とはいえ例えば自動運転システムが誰かの誹謗中傷をすることはないですし、顔認識システムが架空の顔画像を創作することもない。それが、昨今の生成AIでは、文章の生成のみならず画像や動画の生成を含めて、あらゆる場面に適応可能になりました。つまり、ひとつの基盤モデルのリスクシナリオが無限に広がる状況になってきたのだと言えます。

そして二つ目が、「ユーザー側も無限定であること」です。これまでは、AIを活用してアクションを起こしていく場合、それができるのはごく一部の限られたエンジニアだけでした。しかし、自然言語を通じたインターフェースやプロンプトが用意されている生成AIでは、誰もが簡単に使えるようになったのです。そうなると、従来型の特定の目的に使うAIのように、主にエンジニアを中心にリスク管理を行っていくアプローチが通用しなくなってくる。AIを使って、「どこで、誰が、何をするのかわからなくなる」ということですね。そうなると、組織マネジメントの観点からも問題になってきますし、社会一般でどういったリスクが出てくるのかを事前に特定しておくことが、非常に困難になるわけです。

- 西村

- 確かに生成AIはガバナンスの対象が広がりすぎてしまっていて、ルールや仕組みに落とし込む上での難しさがありますよね。さらに、生成AIのアウトプットに対する著作権の問題やプライバシーのリスクも考えられます。

- 羽深

- 生成AIのリスクは、大きく分けて「生成AIの技術的限界によるリスク」と「生成AIが優秀すぎるがゆえに生じてしまう社会的なリスク」という二つの側面があると思っています。技術的限界に由来するリスクとしては、ハルシネーション(事実と異なる回答)やプロンプトインジェクション(悪意のあるプロンプト入力によって不適切な回答が出てしまうこと)の問題などが挙げられます。社会的なリスクの典型例は、フェイクコンテンツです。あまりに本物そっくりのコンテンツを作り出せてしまうがために、個人の尊厳や民主主義に害が及ぶ可能性も指摘されています。特に2024年は米国や欧州はじめ世界各地で重要な選挙が行われるので、フェイクコンテンツが社会に与えるリスクは大きな注目を集めています。また、著作権を含む知的財産の問題も非常に大きいです。少し前まで、まさかAIが、人間が作ったものと区別できないようなコンテンツを作れるようになるとは、誰も想定していませんでした。現在、著作権法の解釈を巡って大きな議論が巻き起こっていますが、既存社会の枠組みの中で作られた法と照らし合わせどう判断していくかというだけでなく、社会の前提が変わったことを踏まえて「ルールを作り直す」ところまで踏み込んで議論する必要があると感じています。

生成AIが身近になったからこそ、「AIガバナンス」の設計が重要に

- 西村

- 生成AIは技術起因のテクニカルな問題以上に社会全体に与える影響が大きいからこそ、民主主義の分断というネガティブな側面もありますし、一部の人たちだけに利益が集約されないような形での利用形態を考えていくことも重要です。まさに、新しい技術を起点とした社会の捉え直しのような側面があるということが、羽深さんのお話で理解できました。続いて、落合さんの意見もぜひお聞きできればと思います。

- 落合

- これまでの機械学習などのAIは、一部の専門性を持った人が設計しそれを大多数が使う、という構図が前提でしたが、生成AIの登場によって一般の人たちにとってもAIの業務利用のための設計を考えやすくなり、効率化や省力化につなげるために生成AIをどうカスタマイズしていこうか、と多くの人が自ら考えるようになりました。そのため、“生成AIを適切に利用できる状態になっているのか”という点も含め、誰かに与えてもらう・決めてもらうのではなく、我々自身が「AIのガバナンス」を設計していく段階に入ってきたのだと解釈しています。また羽深さんから民主主義のお話もあったと思いますが、AIが何かを識別するだけではなく何かを作れるようになったことで、フェイクニュースや偽物を作ったりという技術についても、相当レベルが上がっていると感じています。この部分はやはり一層重要な論点になってくるのではないのでしょうか。偽情報の拡散への対策について、社会全体として見れば民主主義という広義な話になりますし、個別の企業として見るならば、サイバー攻撃への対処をどう考えていくかという話になるということです。

すべてのリスクをつぶすのではなく、優先順位をつけた「アジャイル・ガバナンス」が求められる

- 西村

- これまでのガバナンスの対象は主にAIの開発者でしたが、2023年12月に日本政府から示された「AI事業者ガイドライン」に照らし合わせると、それがAIサービスの提供者や利用者にまで広がってきています。お二人は政府のガイドラインに対し、現時点ではどのような所感をお持ちでしょうか。

- 落合

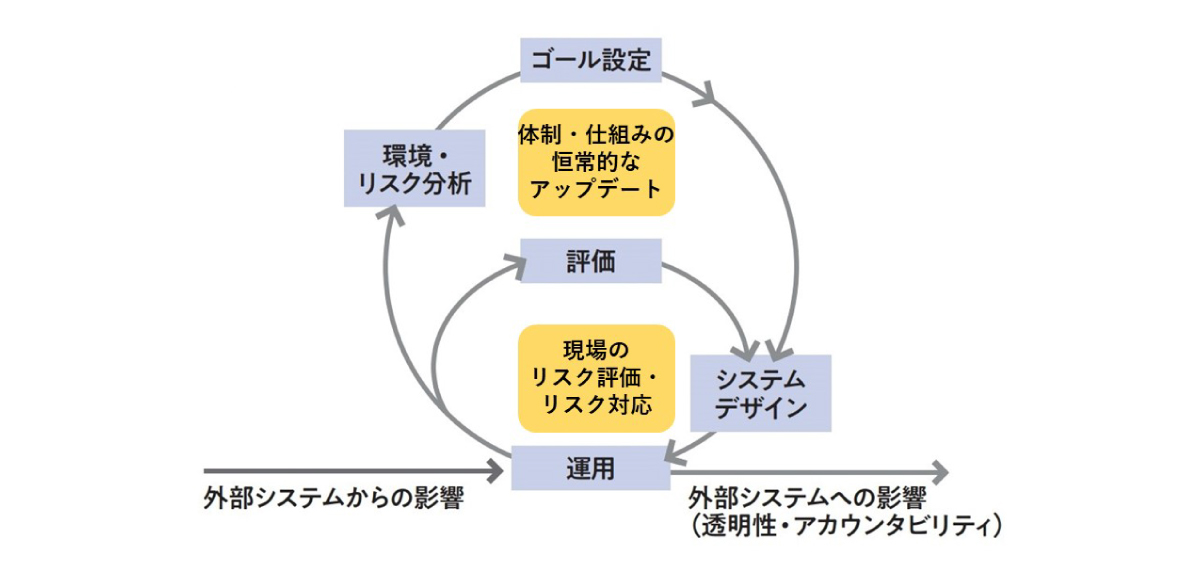

- 生成AIの利活用で起き得るリスク、懸念のすべてに対処しようとすると、どうしてもシステムやルールがうまく作れなくなります。これは生成AIに限らず他の分野にも言えることですが、ガイドラインとして示せる限界も踏まえた上で、どう取捨選択していくかが最も重要だと考えています。企業が経営判断を行っていくなかで、生成AIにはリスクがあるからとすべてのことに対して対策を講じなければ実施できないというものだと、経産省が提唱し、今回総務省との共通ガイドラインに導入される「アジャイル・ガバナンス(常に周囲の環境変化を踏まえてゴールやルール、制度を継続的に評価し、アップデートしていくガバナンスモデル)」にまったく反することになります。生成AIのような新しい時代の技術を利用する場合、「リスクがあるので、すべてを叩き壊してから始める」という旧来の日本型のやり方ではなく、アジャイル・ガバナンスが特に求められるわけです。

1から10まで全部、ではなく特にリスクが高い部分を特定したうえで、まずはそこから企業としてもしっかり対応していくことが望まれると思いますし、そこをもう一段ブレイクダウンしていくための取り組みが重要になってくるでしょう。

「現場」と「体制」の両軸でリスクマネジメントのループを回していく重要性

- 西村

- 技術起点で、社会および実務へのインパクトが大きくかつリスクが高いのは、コントロールできない生成AIのハルシネーションだと思いますが、現状のガイドラインでは、この辺りがすべからく「適切な利用」や「適正な判断」という表現になっており、事業者や利用者自身が完全にはリスクをコントロールできないですし、どこまでが「適正」なのかの線引きも難しいと思います。ここをもっとブレイクダウンしていく必要性を感じていますが、技術的限界が必ずあるところでの、アジャイル・ガバナンスのあり方はどのように考えればよいでしょうか。

- 羽深

- 企業におけるアジャイル・ガバナンスの基本的なフレームワークやマインドセットとしては、日本のAI事業者ガイドラインや、米国のAIリスクマネジメントフレームワーク、AIマネジメントシステムに関する国際標準などにおいて、“二重のフィードバックサイクルを回していく“ことが提唱されています。1つめのサイクルは、リスク担当部門がきちんとリスク評価をし、いくつかの対応オプションの中から適切なリスク対応を選択していくというものです。そして、それらをステークホルダーにも明確に説明し、フィードバックに基づいて対応を見直すというサイクルを回していきます。しかし、生成AIを取り巻く環境は物凄いスピードで変化していきます。そこで、2つめのフィードバックサイクルを回す必要が出てくる。すなわち、どういうプロセスで、何をリスクと捉え、どのように評価していくのか。あるいは、リスク状況や環境の変化に対して、どういう組織体制で対応していくのが望ましいかなど、「体制面」や「仕組み面」においても常にアップデートを続けていくということです。

アジャイル・ガバナンスの基本的な考え方

(出典:経済産業省 「GOVERNANCE INNOVATION Ver.2:アジャイル・ガバナンスのデザインと実装に向けて」報告書 2021年2月)

生成AIに関する具体的なリスクへの対処方法ですが、まず、契約面でリスクヘッジできるポイントは多くあります。例えば海外の生成AIモデルの中には、その生成物に関して第三者が著作権を主張してきた場合に、AIモデルの提供者自身が責任を負うという条項を入れているものもあります。これにより利用者である企業は、仮に生成AIの生成物が第三者の著作権を侵害していたとしても、法的なリスクを回避することができるのです。また、生成AIから不適切な出力がなされないような技術的なガードレールを施しているサービスも多くあります。但し、それらの内容や制度、契約内容は刻一刻と変化しますので、生成AIを利用する企業はきちんと評価し続けなければなりません。

社内でのリスクマネジメントにおいては、従業員向けのマニュアルを作ったり研修を実施したりすることが効果的でしょう。その際には、コンプライアンスやガバナンスを担当する社員向けの詳細版マニュアルと、全従業員が直感的に理解できるような簡易版マニュアルの2つを用意するといった対応も考えられます。生成AIのリスクや、生成AIの提供者との契約内容が変われば、マニュアルの中身やそれに伴う研修、テストの内容も変えていく必要があるため、そういった全体的な仕組みをどのようにアップデートしていくかということは、経営層がリーダーシップを発揮して責任を持って取り組むべきことです。

生成AIは責任の所在が不明瞭。“誰が悪い”から脱却し、良循環を生む制度作りを

- 西村

- 「現場」と「体制」の両軸でループを回していくことの重要性がよく理解できました。一方で、アジャイル・ガバナンスを進めるには、今までにはなかった人的、資金的コストが発生すると思っています。アジャイル・ガバナンスへ投資することで、自社へのリターンにつながるという認識を企業が持つためには、どういう環境が整えばいいのでしょうか。

- 羽深

- やはり、制度面をアップデートするしかないと思います。現段階でも、生成AIの利用によって著作権侵害の問題やSNS等での炎上リスクが一定あるわけですが、こういったことに関して現行の制度がうまく対応できているかというと、必ずしもそうでない部分もある。というのも、今の制度は問題が起きたときに責任の所在を明確にすることが前提になっている一方、昨今の社会で実際に起きるリスクというのは、さまざまな要因が相互に関連したものだからです。つまり、必ずしも“誰が悪い”と決めることができないんですね。さまざまな予防線を張っていたにもかかわらず最終的に問題になってしまったのにはどのような原因があったのか。ヒューマンエラーがあることを想定してガバナンスを定めていくべきだったのに、そこに足りなかったものは何か。誰が悪かったかを特定するよりも、よりシステマティックにリスクを捉え、各所から情報を収集して全体を良くしていく方向に動機づけるような法システムを導入していくことが重要になるのではないでしょうか。

EUでは生成AIを含むAI全般をターゲットにした「AI法」の策定が大詰めを迎えています。日本では、このようなAI全体をカバーするような法律を作る動きはありませんが、2月には、自民党のプロジェクトチームの有志から、大規模な基盤モデルを想定した「責任あるAI推進基本法」の素案が提案されています。法規制は、一定の高リスク分野では必要なことですが、その場合も、イノベーションを阻害しないように、善良な事業者にとって過度な負担とならないような内容にする必要があるでしょう。また、そうした事前の規制だけでなく、問題が起きてしまった際の制裁や責任の在り方についても工夫が必要です。「問題を起こしたら罰します」というだけでは、誰もが情報を隠すようになってしまう。そのため、事後的に報告や調査への協力、改善へのコミットを示した企業に対しては、一定の責任を免除するようなインセンティブのような仕組みも考えられるかもしれません。生成AIのサービスが世の中で普及するにあたって、AI開発者、AI提供者、AI利用者などステークホルダーが多く、責任分解が困難だからこそ、犯人捜しよりもガバナンスの仕組みの中に、制度改善を各自が自発的に行えるようなインセンティブ設計があることで、ガバナンスの在り方がより良い方向に自走できることを目指すのが良いのではないでしょうか。

生成AIを活用する意義や必然性が高まれば、アジャイル・ガバナンスの取り組みが浸透していく

- クロサカ

- ここまでお話いただいたなかで、とりわけ初期の段階では「何をどうすればいいかわからない」という方々が多いため、ガードレールを作っていくという観点はとても重要だと考えています。一方アジャイル・ガバナンスの考え方は、 企業が自発的に取り組んでいくというものですが、アジャイルが苦手な日本企業は多いと感じています。実際に各社が生成AIのガバナンスに向けて動きながら、生成AI自体の進化や取り巻く状況の変化についていくという器用なことなんてできないと考える日本企業も少なくないのではないでしょうか。そういった企業においてアジャイルの取り組みがしやすくなるヒントがあればご示唆いただけますでしょうか。

- 羽深

- 私は、日本人は変化に柔軟に対応していくことは本来得意分野なのではないかと思っています。お互い阿吽の呼吸で理解し合えることだったり、社会的に共有された規範や常識で考えて分別を判断したりできるのが、日本人の良い面だと言えるように思います。もちろん、リスク回避のために制度的な一定の歯止めは必要ですが、必ずしも既存のガイドラインやマニュアルに縛らなくてもいいということを、まずは我々の中で共有する必要があるでしょう。基本的には現場に任せるスタンスがいいと思います。それを踏まえたうえで、著作権の問題など生成AIがもたらす課題や利益状況については社会全体で共有していき、法改正なども含めパブリックに議論していくことも重要だと考えています。

- 落合

- ひとつ考えられるのは、日本企業が最新のテクノロジーを活用していくことに、若干回避する傾向があることです。“ITを導入しなくてもどうにかなる”という観念が、依然よりは弱まっているものの、まだ企業によっては強く存在していることからも、まずは生成AIの必要性に関する認識を持つことが、おそらく決定的に重要なのではと思います。今までの日本企業は昭和までの成功体験が多すぎたというか、テクノロジーを利用せずともマニュアルの動作で他国ができないほどに、利便性があり包摂性がある社会やサービスを形成してしまっていた、という逆転現象があったので、どうしても最新の技術に対して必要性を認識することが難しかった。しかし、やはりテクノロジーの活用はビジネスを加速度的に変えていくわけで、実際生成AIの現実社会での活用については、海外企業がものすごい勢いで浸透してきており、生成AIについても、日本企業が使用している割合が海外企業よりも少ないという統計なども指摘されつつあります。しかし、一定のところではテクノロジーの進化によるサービスの変化が加速度的に増大し、マニュアルが勝っている状況も維持し難い場面が増えるでしょうし、また人口減少、働き手不足の中でどうしてもマニュアルは限界に直面することになります。そういったなかで、日本企業も必然的に取り組まざるを得ないという状況が生まれてきていると思っています。

- 羽深

- 日本はハードウェア文化というか、「物になったものが価値である」という意識が伝統的に非常に強い。一方で、形のない「データ」に対しては、広く社会で活用してもよいという認識が実は高いのではないでしょうか。実際に、GDPRなど厳格な要件を課しているヨーロッパ諸国と比べて、日本の政策を見渡してみてもAIやデータの利活用に向けた法改正が相当なされている印象で、それが日本における特徴的な点だと考えています。しかし、やはり“持っているデータから何か新しい価値を生み出す”企業側からすると、自分たちが相当のコスト、時間を投下して蓄積してきたデータを外にシェアするというのはかなりハードルが高い。そういったときに、企業が第三者に対してデータをシェアしても当初の目的通りに使われて、なおかつ第三者に流出したり目的外利用されたりしない仕組みの構築ができると、生成AIの活用に必要なデータにおいてもアジャイルな取り組みが進展しやすくなるのではないでしょうか。

人間の普遍的な価値を生成AIによってエンパワーしていく

- 西村

- 最後に、今までのお二人からのお話を踏まえて、これから生成AIが生活者の暮らしをどう変えていくのか。こういう風に変わっていけばいいのではという将来の期待を込めて、ご意見を頂戴できれば幸いです。

- 羽深

- 生成AIが社会にもたらす利益というのは、ガバナンスや制度作りの点からも相当インパクトの大きいものだと捉えています。例えば、生成AIの文脈ではバイアスがよく問題になりますが、逆にAIを使うことで、今の社会に存在しているバイアスを発見するという方向にも使うことができるでしょう。また、民主主義のなかでみんなが話し合って決めていく際に、人間が何万人もの意見を集めて、それをうまく論点整理していくことは不可能です。しかし生成AIを使えば、さまざまな人の雑多な意見を集約して、論点に対するそれぞれの意見がどう分布しているのかということも瞬時に分析できるかもしれない。このように、我々のルール作りをより効率化し、かつ継続的にアップデートすることができるのも生成AIが持つ可能性のひとつです。

先ほど、境界が溶けるといったお話もありましたが、人の立場の境界だけではなくて、生成AIのメリットとデメリットの境界も溶け合い、混ざっていくなかで、最終的には人権や民主主義、あるいはサステナビリティといった、我々が生成AIの時代よりもはるか昔から大切にしていた普遍的な価値を、生成AIによってエンパワーしていく。それこそ、我々人類が描くべき未来だと思いますし、 それにあたって不可避なリスクをどうやってコントロールしていくのかというのを考えるのがガバナンスだと言えます。

- 落合

- 日本は人口減少社会や過疎化など、地域社会の維持がこれからより難しくなってくると思っています。構造的にさまざまな地域共通でできることを作っていくことも重要ですが、人でなければできないところを特定した上で、機械や生成AIにできることはそちらに任せていく。過疎化が進む地域における社会機能の維持や継続性の観点からも、生成AIは重要なパーツになるだろうと考えています。また、企業のデータをシェアしたその先に、情報技術を使ってどういう課題を解決するのか、という目的があってこそのデータやガバナンスの整備だと思いますので、 そこの目的をしっかり共有していきながら、生成AIをどう活用していけば人間社会がより良くなっていくのかを考えていくのが望ましい姿ではないでしょうか。アジャイル・ガバナンスの観点でも国のループもあれば、個別のプレイヤーのループもある。それぞれが違う歯車を担っているわけなので、一刻も早く生成AIの必要性を実感しながら、利用を開始して一つでも実務を変え始めることが肝になるでしょう。

この記事はいかがでしたか?

-

落合 孝文氏渥美坂井法律事務所・外国法共同事業 シニアパートナー弁護士

落合 孝文氏渥美坂井法律事務所・外国法共同事業 シニアパートナー弁護士

プロトタイプ政策研究所 所長

スマートガバナンス株式会社代表取締役共同創業者慶應義塾大学理工学部数理科学科卒業。同大学院理工学研究科在学中に旧司法試験合格。森・濱田松本法律事務所で約9年東京、北京オフィスで勤務し、国際紛争・倒産、知的財産、海外投資等を扱った。渥美坂井法律事務所参画後は、医療、金融、国土交通分野、ITなどの業界におけるビジネスへのアドバイス、新たな制度構築などについて活動を行っている。また、スマートガバナンス株式会社を創業しAIガバナンス整備に関する業務を行う。政府、民間団体の様々な活動に関与しており、内閣府規制改革推進会議スタートアップ・投資WG座長、デジタル庁デジタル関係制度改革検討会委員、総務省AIネットワーク社会推進会議AIガバナンス検討会委員等を務める。

-

羽深 宏樹氏スマートガバナンス株式会社 代表取締役CEO

羽深 宏樹氏スマートガバナンス株式会社 代表取締役CEO

京都大学大学院法学研究科特任教授・弁護士東京大学法学部卒、東京大学法科大学院、スタンフォード大学ロースクール修了(LLM, フルブライト奨学生)。日本・ニューヨーク州弁護士。AIをはじめとするデジタル社会のガバナンスについて研究すると共に、企業や公的機関にアドバイスを提供している。2020年、世界経済フォーラムGlobal Future Council on Agile Governanceによって、「公共部門を変革する世界で最も影響力のある50人」に選出。主な著作に、『AIガバナンス入門—リスクマネジメントから制度設計まで』(ハヤカワ新書)。政府のAI事業者向けガイドラインの策定WGメンバー、東京大学客員准教授、米国シンクタンクCSISのフェローも務める。

-

クロサカ タツヤ氏慶應義塾大学大学院政策・メディア研究科 特任准教授

クロサカ タツヤ氏慶應義塾大学大学院政策・メディア研究科 特任准教授

株式会社 企(くわだて) 代表取締役慶應義塾大学大学院政策・メディア研究科修了。

三菱総合研究所を経て、2008年に株式会社企(くわだて)を設立。

通信・放送セクターの経営戦略や事業開発などのコンサルティングを行うほか、総務省、経済産業省、内閣官房デジタル市場競争本部、OECD(経済協力開発機構)などの政府委員を務め、5G、AI、IoT、データエコノミー等の政策立案を支援。

公正取引委員会デジタルスペシャルアドバイザー。

Trusted Web推進協議会タスクフォース座長。

オリジネーター・プロファイル技術研究組合事務局長。

近著『5Gでビジネスはどう変わるのか』(日経BP刊)、『AIがつなげる社会』(弘文堂・共著)他。

-

博報堂DYホールディングス

マーケティング・テクノロジー・センター 室長代理

株式会社Data EX Platform 取締役COOThe University of York, M.Sc. in Environmental Economics and Environmental Management修了、およびCentral Saint Martins College of Art & Design, M.A. in Design Studies修了。

株式会社博報堂コンサルティングにてブランド戦略および事業戦略に関するコンサルティングに従事。株式会社博報堂ネットプリズムの設立、エグゼクティブ・マネージャーを経て、2018年より博報堂DYホールディングスにて研究開発および事業開発に従事。

2019年より株式会社Data EX Platform 取締役COOを務める。2020年より一般社団法人日本インタラクティブ広告協会(JIAA)にて、データポリシー委員会、Consent Management Platform W.G.リーダーを務める。