進化し続けるAIと人間中心のアプローチ AI技術・ガバナンスの最新トレンド【セミナーレポート】後編

生成AIの飛躍的な進化に伴い、今やさまざまな領域でAIの活用が進んでいます。

そんな中、博報堂DYグループは“人間中心のAI技術”を軸に研究開発を行う組織「Human-Centered AI Institute」を設立しました。

AI技術のさらなる進化が加速する今、AIをどう活用すべきか。

そして、どのようなリスク対策が求められているのか。

本記事では、先日開催した博報堂DYグループが主催する“生活者データ・ドリブン”マーケティングセミナー「進化し続けるAIと人間中心のアプローチ:AI技術・ガバナンスの最新トレンド」の様子を編集してお届けします。セミナーレポート記事の後編として、デロイト トーマツ リスクアドバイザリー合同会社の山本優樹氏より、AI規制やガバナンスに関する最新動向を解説いただきます。さらに、最新技術トレンドや企業が今取り組むべきリスク対策について、山本氏と森がパネルディスカッションした様子をご紹介します。前編では、「Human-Centered AI Institute」の代表を務める森正弥が、AIの技術的な進化の方向性や人間中心のAI活用のアプローチについて触れながら、博報堂DYグループの今後のAI活用の取り組みについてご紹介しています。前編はこちら。

<登壇者>

山本 優樹氏

デロイト トーマツ リスクアドバイザリー合同会社

デロイトアナリティクス シニアマネジャー

森 正弥

博報堂DYホールディングス執行役員 Chief AI Officer

Human-Centered AI Institute代表

【第二部】AI規制・ガバナンスの最新動向とAIリスク対策

AI活用によって起こりうるリスクとは

- 山本

- はじめに、私のプロフィールを簡単に紹介させてください。

もともと私は、日本のテック系企業の研究部門に10数年所属し、さまざまな製品やサービスにおけるAI・機械学習の技術開発に携わってきました。その後、デトロイト トーマツ グループに参画後は、AI技術のビジネス導入とリスク対策について、クライアント企業様のお手伝いをさせていただいています。

では、AI活用に伴うリスクについてお話させていただきます。

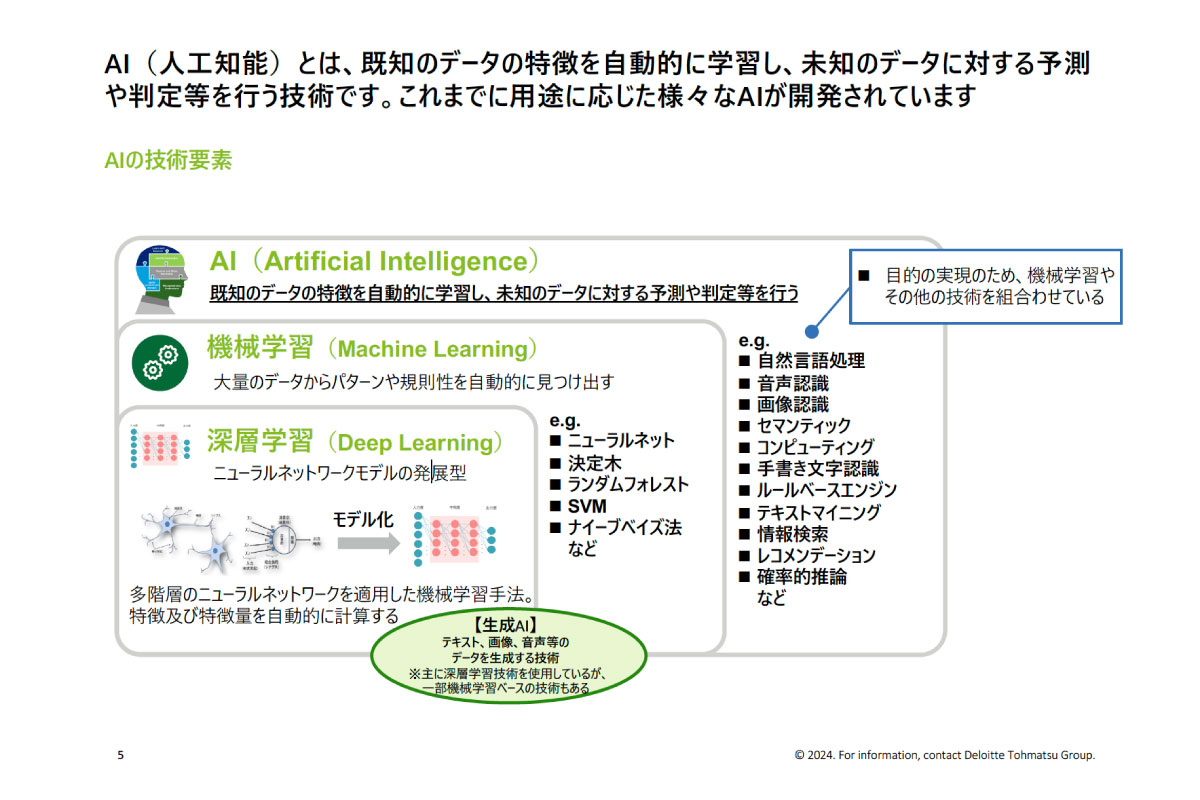

AIとは、簡単に言えば人間の知性をコンピュータで実現する取り組みのこと。大量のデータをAIに与えることで、データの特徴を学習させ、再表現させる技術として確立されてきました。

こうしたことから、データさえあれば、さまざまな領域でAIを活用できる可能性があります。

たとえば、製造業や金融業、流通業など、各業界で独自の活用がなされてきましたし、業界に限らず、経営やマーケティング、人材領域でも活用が進められてきました。

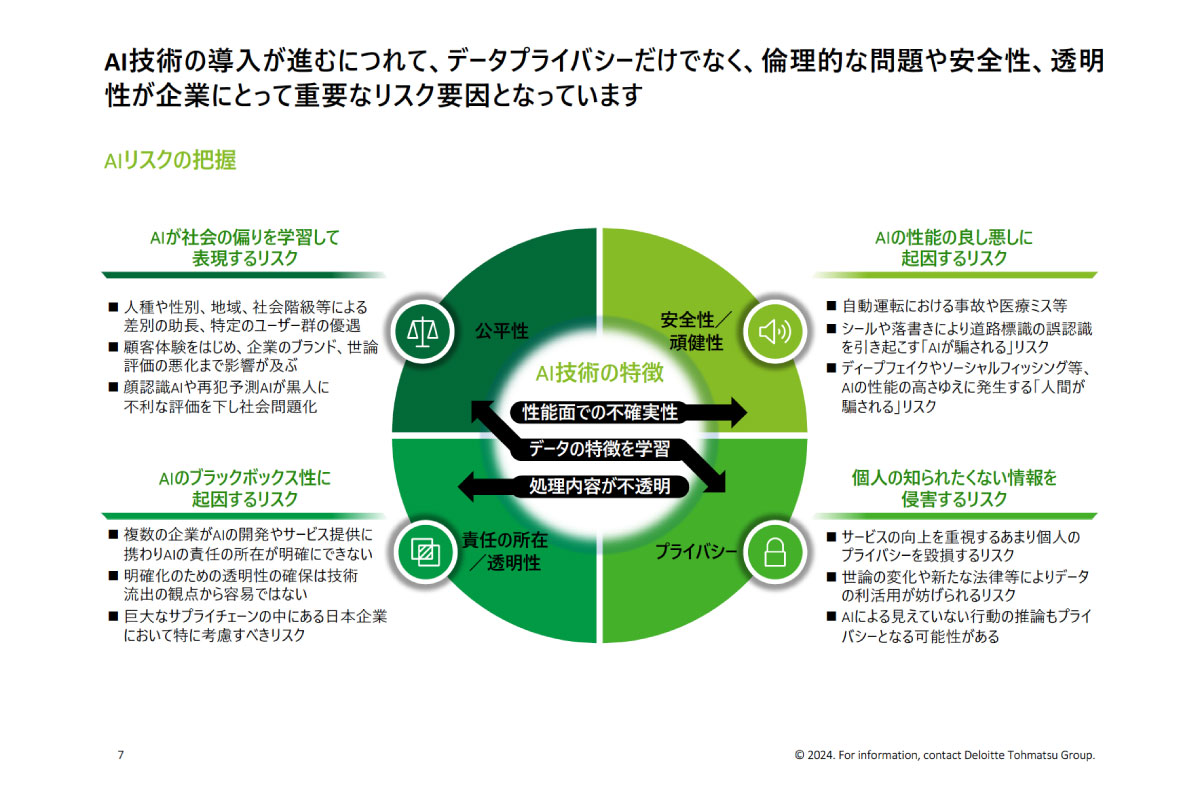

ただ、「データの特徴を学習する」といった特徴は、これまでの「人間がつくったルールに従わせる」技術と比べると、いろんなリスクが発生するおそれがあります。

どのようなリスクが発生しうるのか、3つ挙げさせていただきます。

● 性能面の不確実性に起因するリスク

AIは、原理的に100%の性能を発揮することが難しい不確実性を持った技術です。そのため、自動運転における事故や医療ミスなど、安全性・頑健性の面でリスクが発生する可能性があります。

● データの特徴を学習することによるリスク

たとえば、学習させるデータがなんらかの不公平や不平等性を持っていた場合、再表現時に、AIが不公平な判断をしてしまう可能性も。さらに、サービス向上を目指すあまり、本来与えてはならないデータ、具体的には個人情報などをAIに与えてしまうと、プライバシーの侵害につながるリスクもあります。

● 処理内容の不透明さによるリスク

最近は生成AIの処理が急速に複雑化しており、いかに優れた研究者であっても、実際にどんな処理が行われているのかわからないようなブラックボックス化が進んでいます。そのため、AIが何を根拠に回答を生成しているかといったことを明確にできない説明性に関するリスクや、AIに関する責任の所在を明確にできないというリスクもあるでしょう。

AIのリスクの特徴として、以上お話しした「リスクの多様さ」に加え、「リスクの影響範囲の広さ」「リスク対策のルールがあいまい」といった3つが主に挙げられます。

AIガバナンスのために企業が実施すべき3つのこと

- 山本

- そんな中、重要度が高まっているのがAIリスクへの対策である「AIガバナンス」です。

企業が実施すべきことは、大きく3つあります。

● AI倫理ポリシーの策定

● AIリスク対策のルール・プロセス・体制構築

● AIリスク対策の運用

一つ目は、「AI倫理ポリシーの策定」についてです。

AI倫理ポリシーとは、企業がどのようにAIと向き合い、活用・リスク対策をしていくのか、その方針を公表するもの。クライアントやステークホルダーからの信頼獲得につながったり、事例等の公開によって国や業界のルール形成における一助になったり、また、社員のAIリスクに関する意識が向上したりと、社内外に良い影響をもたらすでしょう。

二つ目が、「AIリスク対策のルール・プロセス・体制構築」についてです。

AIリスクの効率的な低減に向け、どこの部署がどのようなことを実施していくべきか、AIリスクの管理体制の「あるべき姿」の実現に向け、体制・プロセスの整備が必要です。実際に、我々のクライアントがAIガバナンスを導入するにあたり、こういった体制やプロセスの構築からお手伝いさせていただく機会が増えております。

三つ目が、「AIリスク対策の運用」についてです。

ルールやプロセスを通じて、人の手でリスク対策を行っていくことは非常に大切なことですが、最近の生成AIの躍進は凄まじく、人間が想定しないリスクが後から見つかる場合もあります。そこで、AIリスク対策ツールも並行して活用しながら、想定外のリスクを洗い出しておくことも欠かせません。

AI規制に関する最新動向と「AI事業者ガイドライン」

- 山本

- また、AIのリスク対策を考える上で見過ごせないのが、各国の動向です。

たとえば中国では、いち早く生成AIへの暫定的な法規制を施行していますし、アメリカでは、とくに州法において具体的なユースケースに対する規制化が進んでいます。

さらにEUでは、AI全体に対する法規制「EU AI Act」が策定され、今後段階的に適用されていく見込みです。これに関しては罰金等も規定されています。

そんな中、日本にはまだ法的な拘束力を持つハードローはありませんが、ガイドラインなどのソフトローは出てきており、2024年4月には総務省・経産省から、世界的な規制の動きを踏まえた「AI事業者ガイドライン」が発行されました。すでにAIサービスを提供している、もしくはこれから提供していく企業からの注目も集まっています。

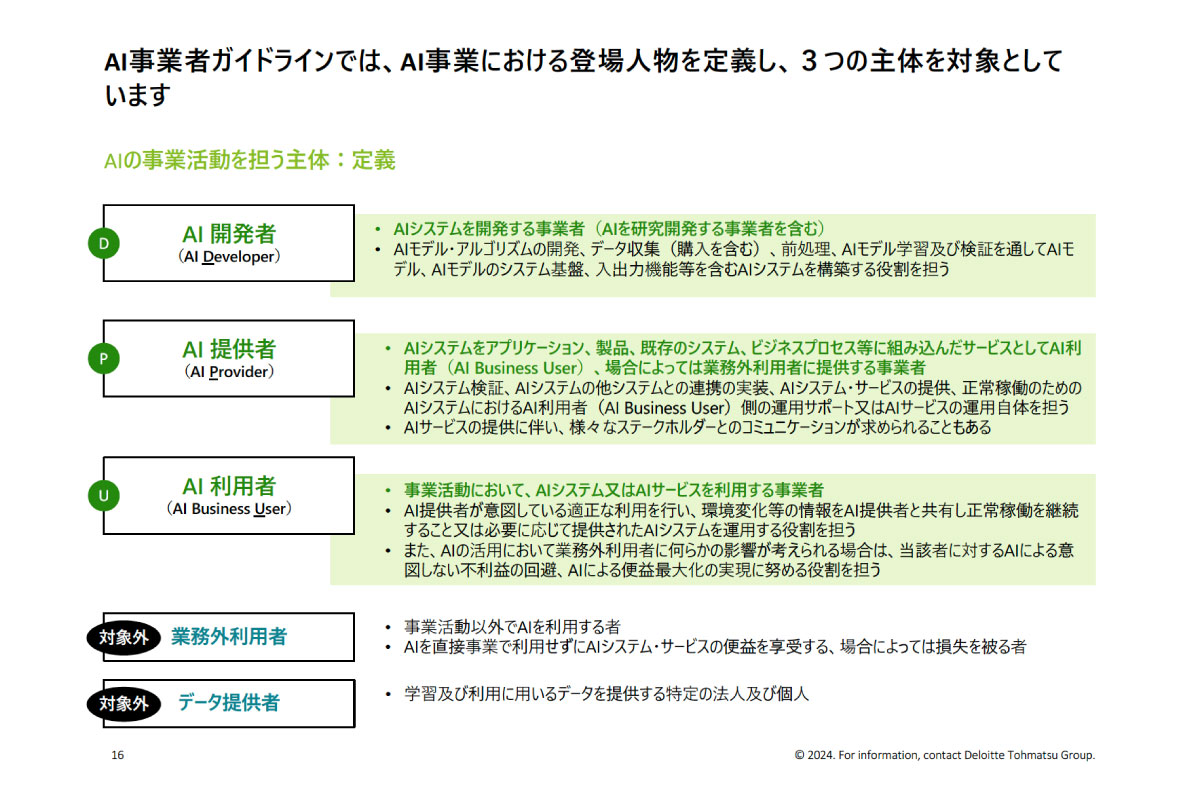

「AI事業者ガイドライン」の大きな特徴は、AI開発者・AI提供者・AI利用者というように“どのような形でAI事業に関わるか”で項目が分けられている点です。

具体的なユースケースをあげて説明します。たとえば、A社における人材採用部門が、書類選考を行う際の参考情報として、A社の開発部門が作成したAIシステムを使用する場合。この場合は、大元となるAIモデルを作成した開発部門が「AI開発者」、AIモデルを搭載したシステムを構築・運用するシステム部門が「AI提供者」、AIモデルを利用する人材開発部門が「AI利用者」となります。そして、これらAI開発者・AI提供者・AI利用者のそれぞれが実施すべきリスク対策がガイドラインにそれぞれ記載されている、ということです。

他にも、無人コンビニにおけるAIを活用した決済システムや、工場などの不良品検知AI、社内チャット ボットや顧客サポートAIなど、あらゆる場合において「AI開発者」「AI提供者」「AI利用者」の3つに分けてリスク対策を考える必要があるのです。

生成AIの進化に伴うさまざまな変化と対策

- 山本

- 生成AIの躍進により、従来のAIリスク対策では対応できない点が出てきているのも事実です。そこで最後に、今後予想される変化と、ビジネス導入時のポイントについてお話させていただきます。

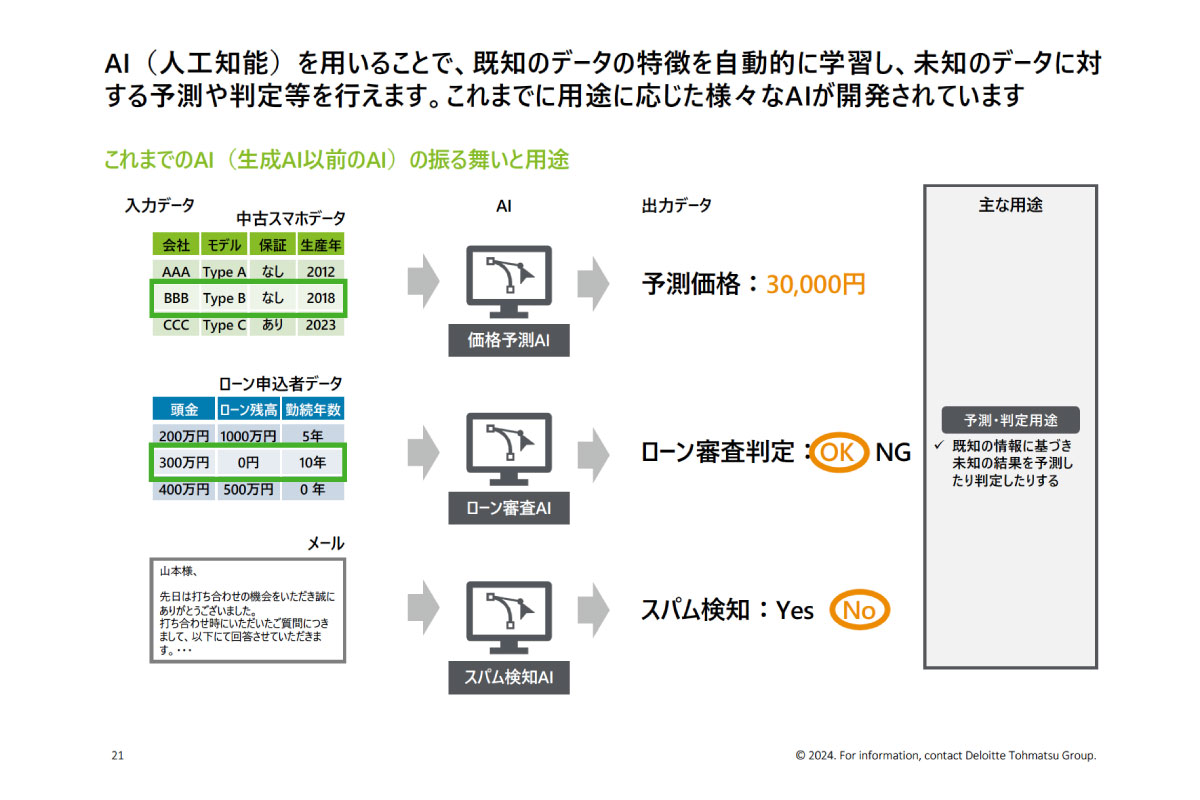

まずは、従来の主流であった「用途特化型AI」から、現在の「生成AI」への変化についてです。

もともと「用途特化型AI」は、価格予測AIやローン審査AIなど、用途ありきで特定のデータをもとに開発されるため、用途ごとにAIを作る必要がありました。

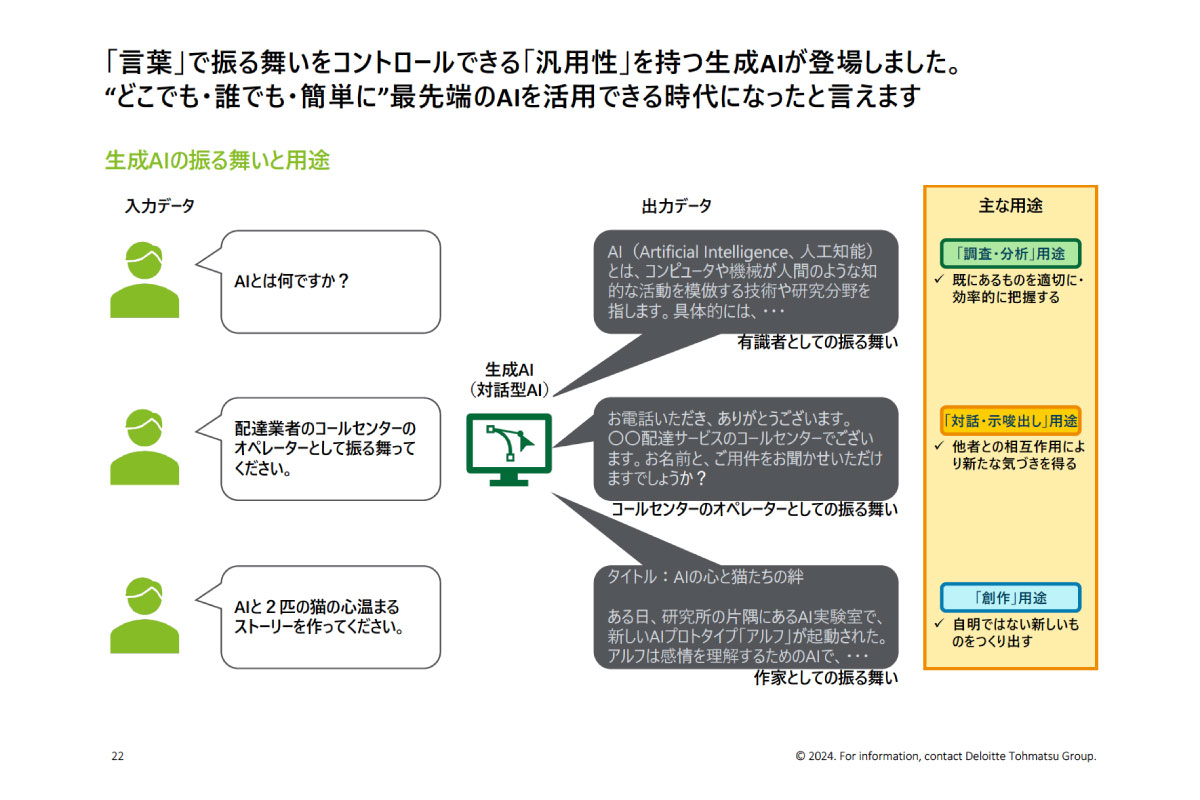

これに対して「生成AI」は、入力された言葉に応じて振る舞いを変えられるという特徴から、一つのAIをさまざま用途で使える、という大きな違いがあります。また、従来は綺麗に構造化された、決まった形式のデータをAIに入力する必要がありましたが、言葉で入力できるのも違いの一つです。これによって、AIを利用できる人が格段に増え、さらに生成AIを搭載したAIサービスを提供する人も増えていくことが予想されます。

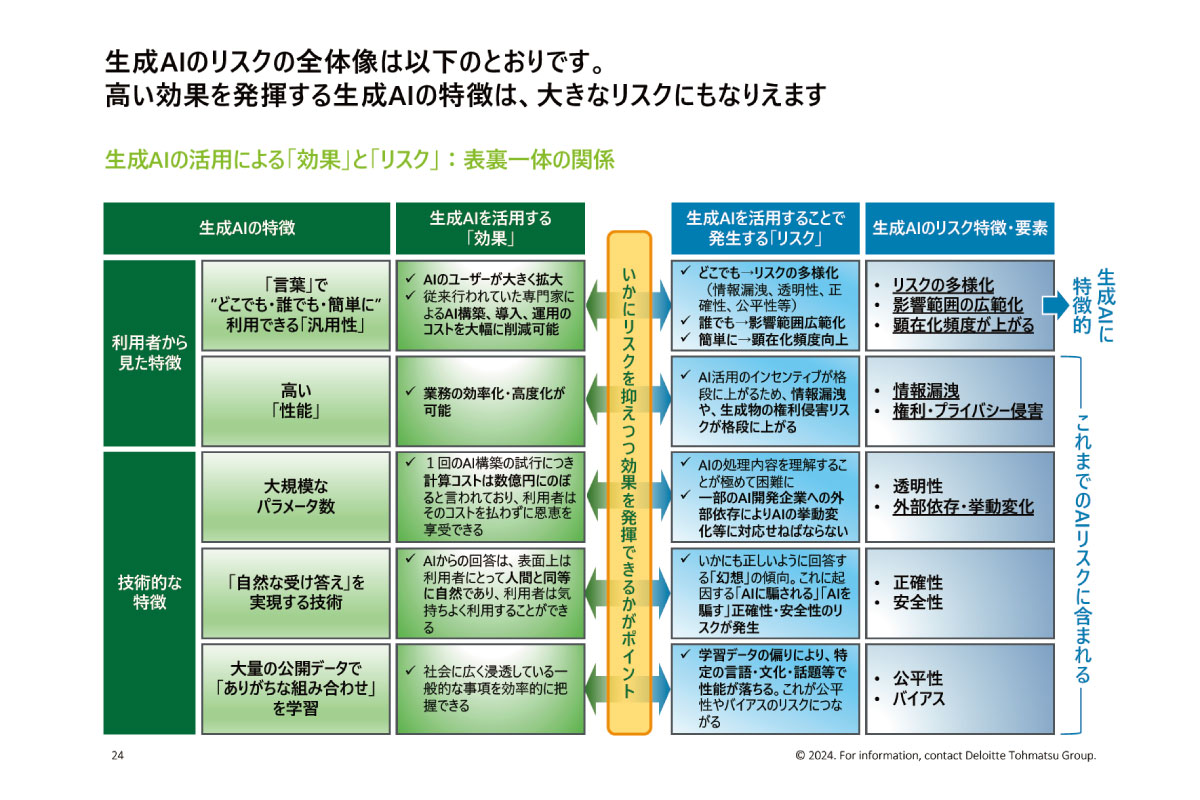

「用途特化型AI」に比べ、さまざまな領域において汎用的な活用が可能な「生成AI」。

すごく魅力的に感じられると思いますが、その効果と表裏一体にあるのがリスクです。

とくに「生成AI」は、誰でもどこでも簡単に利用できるという特徴から、リスクの多様化や影響範囲の広範化など、リスクそのものが大きくなってしまう側面があります。

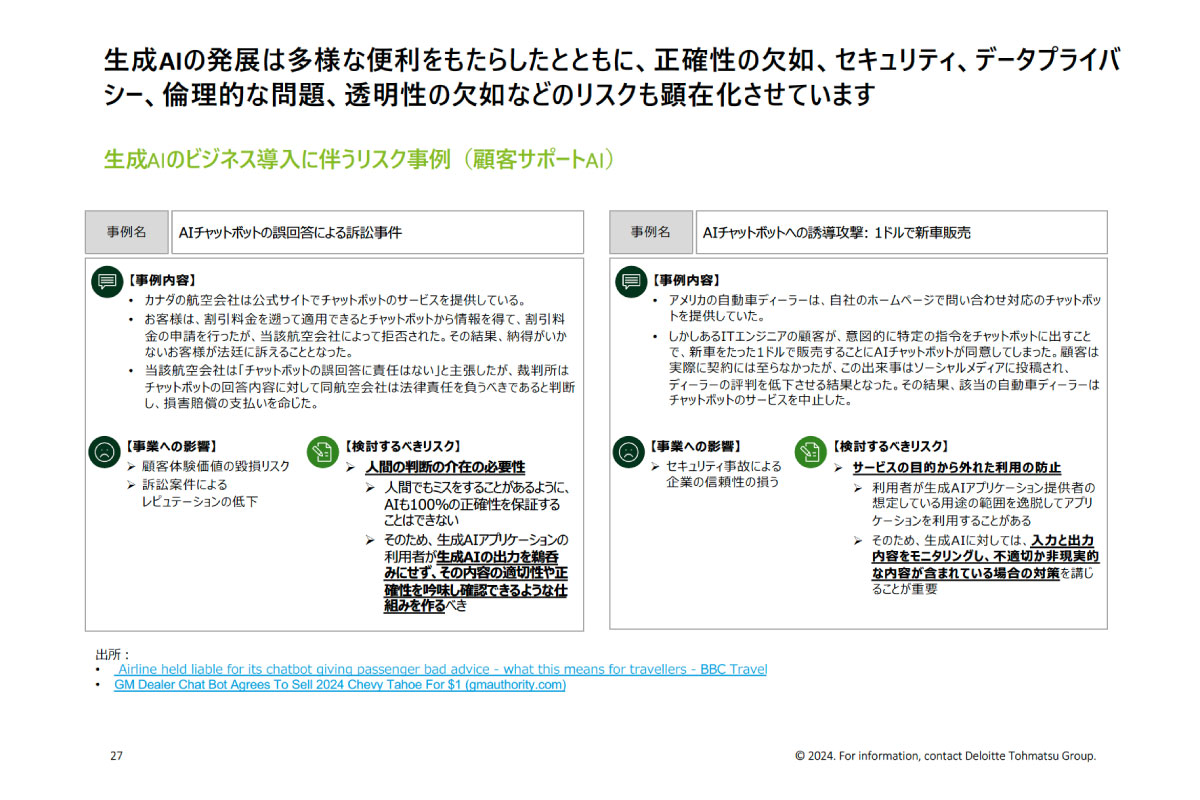

ここで、生成AIのビジネス導入に伴うリスク事例を2件紹介させていただきます。

一つが、カナダの航空会社の事例で、AIチャットボットによる誤回答によってお客様が不利益を被ってしまったことから訴訟が起きたというもの。

もう一つが、アメリカの自動車ディーラーの事例で、顧客がチャットボットのAIを誘導して1ドルで新車を販売するよう仕向け、トラブルにつながってしまったというもの。

このように、AIリスクが企業の信頼性や顧客の体験価値を大きく揺るがす可能性もあるため、一層のリスク対策と知見の獲得が急務になっています。

次に、AIガバナンスの変化についてです。

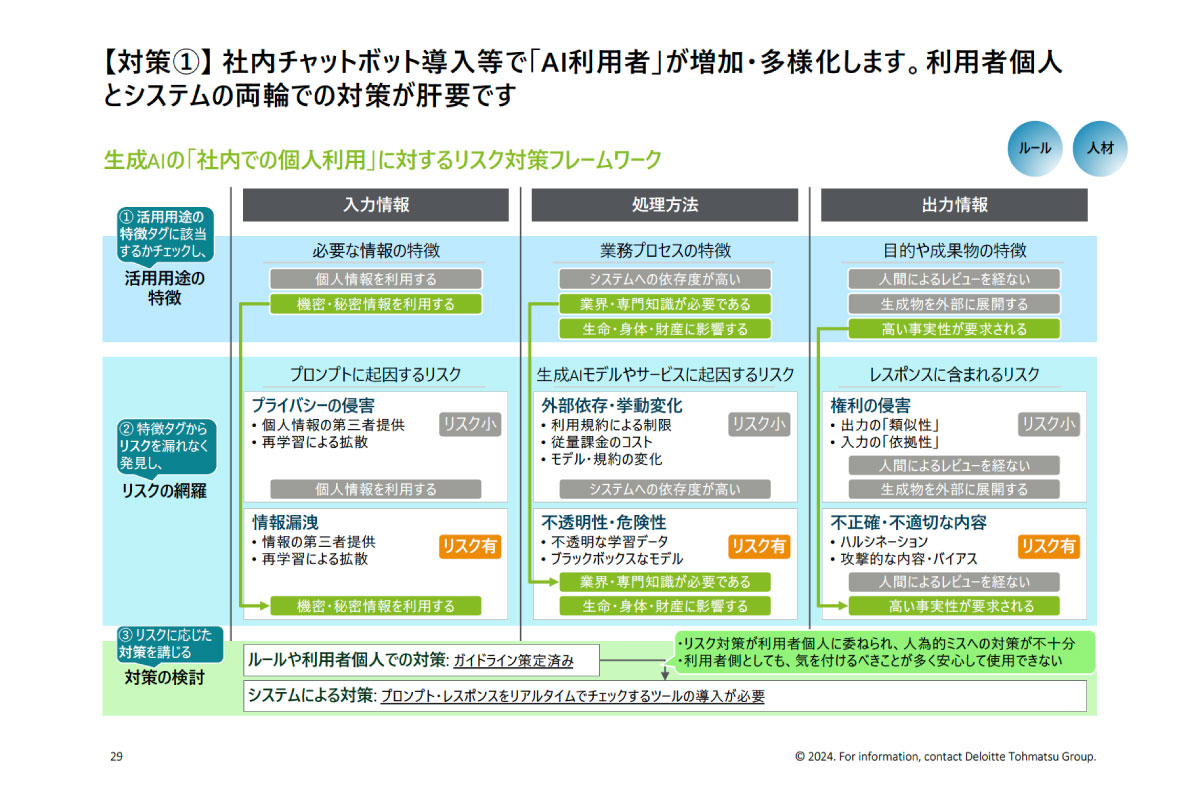

従来のAIガバナンスでは、「AI開発者」「AI提供者」への対策が重点的に語られてきましたが、今後「AI利用者」が格段に増える中では、利用者側への対策も増えていくでしょう。

こちらは、生成AIを社内で個人利用する際、利用者側への対策として考えられるものをまとめたフレームワークです。生成AIへの入力・処理・出力のそれぞれに、どのようなリスクがあるのかを洗い出しています。このようなフレームワークに落とし込むことで、どのようなリスク対策を行う必要があるかが明確になるはずです。

一方で、社内のChatGPTに届く内容を全て人の目でチェックするのは難しいと思いますので、そういう際はツールの活用が有効です。

ユーザーが入力する内容に個人情報が入っていないか、悪意のある入力ではないか、などをモニタリングできるようになることで、リスク対策の強化にも直結するでしょう。

「AIのリスク対策」について、生成AIの躍進による変化や新たな論点にも触れながらお話させていただきました。今回のウェビナーのテーマでもある“人間中心のAI”を考える上でも、AIガバナンスは欠かせないものだと考えています。

【第三部】パネルディスカッション

使い方が広がるほど、技術トレンドは進化する

- 森

- 第三部は、3つのトピックについて山本さんとディスカッションさせていただきたいと思っています。

まずは、AI技術トレンドについてです。

第一部にて私からAIの技術発展について述べさせていただいたのですが、山本さんのお話の中でも「AIの汎用性が広がったことで利用者も提供者も増えている」というお話がありました。

山本さんが今注目しているAI技術があれば教えていただけますか。

- 山本

- 他の技術革新にもつながる可能性を秘めていると思うのは、「マルチモーダルAI」です。

これはテキストに加え、画像・音声など複数の種類のデータ形式を扱えるAI技術なのですが、ビジネスへの導入を考えた時に革新的な変化が起きるのではないかと感じています。

たとえば、これまでデータ活用においてすごく大変だったデータの整理や構造化といった下準備も、「マルチモーダルAI」で画像を読み取るだけでよくなれば、大幅な効率化になりますし、利活用できるデータの幅も一気に広がると思うんです。

- 森

- 整理しなければ使えなかったデータを生のまま使えるようになれば、画像化されているグラフやスキャンしたPDFなども簡単に読み込ませられるようになるので、一気にユースケースが広がっていきそうですね。

- 山本

- そうなんです。まさに、私たちの会社でもそんな取り組みを始めています。データ化が進んでいなかったり、紙をスキャンしたままになっていたりする企業も多いと思いますが、準備が整っていなくてもデータを利活用できるようになれば、イノベーションにもつながりやすくなるはずです。

- 森

- そういう意味では、生成AIのポテンシャルについては実はまだ開拓されていないとも言えますよね。

たとえば、いろんな企業が分野ごとにまとまったカオスマップってあるじゃないですか。あれをマルチモーダルAIで読み込むと、一瞬でリスト化されてURLまでつけてくれるんです。今までは眺めるだけだったカオスマップが、データになると活用できるようになる。そういうことが、いろんな場面で出てくるような気がしていて、今後はもっといろんな使い方や事例が出てくるのではないかと思いますね。

- 山本

- まだまだ生成AIでできることに対して事例が少ない印象はありますね。使い方が広がっていけばいくほど、技術トレンドも進化していくのではないかと思います。

AI技術の進化に常に目を配り、柔軟な対応を

- 森

- 次のトピックは、AI規制・ガバナンスの動向についてです。

AIリスクの考え方や規制の最新動向などについて解説いただきましたが、直近でいうとAI規制やガバナンス周りでどのような展開がありそうでしょうか。

- 山本

- プレゼンの中で触れさせていただいた「EU AI Act」は、いよいよ段階的な適用がスタートしているところです。これはEUで適応される法律ですが、たとえば日本企業であってもEUでビジネスを展開していて、AIを活用するとなると域外適用の対象になる可能性があるので、喫緊の対応が求められることと思います。

- 森

- 他国でもさまざまな規制が出てきていますが、これらの規制の動きに対して日本企業が何か対応しておくべきことはありますか。

- 山本

- そうですね。今後整備されていく日本の規制は他国の動きを踏まえたものになることが予想されますので、まずは世界の動きをしっかり認識しておくことが欠かせません。

とくに「EU AI Act」では、どのようなユースケースのリスクが高いのかといった、ユースケースとリスクの程度の対応が挙げられているので、それを参考に自社のAIのリスクの程度を確認したり、「AI事業者ガイドライン」に合わせた取り組みを進めたりしていくといいかと思います。

また、技術向上や機能追加によって新たなユースケースが次々に生まれていくのが生成AIの特徴ですが、そうなると当然、今想定していないリスクも出てくるはず。現在の規制が全てのリスクを網羅しているわけではないということをまずは認識いただいて、常に社会の状況や起こりうるリスクに目を配りながら、柔軟に対応していく姿勢が重要だと思いますね。

- 森

- なるほど。AI技術の進化って本当に早くて、どんどん性能も上がっているので、想定していないリスクもきっと出てきますよね。だからこそ、今考えられているリスクだけに気を付けるのではなく、今後出てくるリスクにもアクションしていくことを念頭に置いておかないといけませんね。

- 山本

- その通りだと思います。また、個人的にリスク対策を行う上で大切なのは、たくさん使うことだと思っています。使うことで、今の生成AIでどのくらいの精度が出せるのか、どのような用途で使えるのか、そしてそのような活用がどんなリスクを孕むのか、といった具体イメージが掴めるようになると思います。そうやって使いこなしていくうちに、もう少し技術が進歩したら何がどこまでできるようになるのか、先を見通せるようにもなると思いますから。活用することで、リスク対策にもつながる。そんな、攻めと守りの両立がガバナンスにおいても必要だと思うんです。

だからこそまずは、AIリテラシー教育なども企業内で行いながら、AIを使いこなせる人材を増やしていくことが、真っ先にやるべきことなんじゃないかなと思っています。

“守り”だけでなく“攻め”のためのAIガバナンスを

- 森

- 最後のトピックが、人間中心のAIについてです。

AIと人間の関係性について、山本さんはどんな展開を期待されていますか?

- 山本

- 私は普段から生成AIを活用していますが、すごく便利なんですよね。業務はもちろん生活にも使っていて「基本的に、使えないところはないツールだな」という感覚です。

そもそも人間は、言葉をはじめとしていろいろな道具を使いこなして進化してきたとも言われていますが、このAIも新しいツールの一つと捉えています。

そう考えると、今はまさに、この先進的なAIというツールを人間社会に整合させていくプロセスの真っ只中。「人間」が持つ社会的な価値観や文化などを踏まえながら整合させていくことを考えると、“人間中心のアプローチ”が非常に重要なんじゃないかなと思います。

- 森

- ありがとうございます。単に、便利な道具として利便性だけを追求するのではなく、価値観の反映や価値観に合わせた使い方の開発なども進めていく必要がありそうですね。

最後に、視聴者様から一つ質問をいただいているので、紹介させていただきます。

「企業がAIを安全に活用するためにまず何から取り組めばいいですか」という質問なのですが、山本さんいかがでしょうか。

- 山本

- 先ほどの回答と重複してしまうかもしれませんが、まずは“使うこと”だと思います。

生成AIはプロンプトの言葉によってアウトプットが大きく変わりますが、それはつまり、日々言葉を使っている私たちであれば、いかようにでもできるはずなんです。

だからこそ、何かしようと思ったらとりあえずAIを使えないか試してみるとか。その先で「今後AIがどう進化していくか」「AIとどう付き合っていくべきか」を自然と考えるうちに、リスク対策の基本的な考え方についても理解が深まっていくのではないかと思います。

- 森

- そうですね。よく「ガバナンスは、“守り”ではなく“攻め”のためにある」と言われますが、“守り”を考えていくために“攻め”ることも重要である。今の山本さんのお話にも通じる部分があると思いました。守りと攻めの両方を、いかに相互に高めていくか。そういう意識をまずは持つことが大事かもしれませんね。

- 山本

- その通りだと思います。生成AIは、誰にでも活用できることが特徴だと思うので、ぜひみなさんにはどんどん活用してみてほしいですね。

この記事はいかがでしたか?

-

山本 優樹氏デロイト トーマツ リスクアドバイザリー合同会社

山本 優樹氏デロイト トーマツ リスクアドバイザリー合同会社

デロイトアナリティクス シニアマネジャー世界的な電機・エンタテインメント企業の国内および米国の研究拠点にて、AI等の先端テクノロジーの研究開発および同成果の製品・サービス・国際標準への導入等を経て現職。企業のビッグデータ分析、AIのビジネス導入、AI活用に向けた組織構築・人材育成、AIの活用に伴う社会的なリスクの回避に向けたAIガバナンスの実践等の経験を通じ、テクノロジーとデータを活用したビジネスの改善に強みを持つ。2022年から東京大学未来ビジョン研究センター客員研究員。生成AIの社会導入とAIガバナンスの実践の高度化に関する調査研究に従事。

-

博報堂DYホールディングス執行役員 Chief AI Officer

Human-Centered AI Institute代表外資系コンサルティング会社、インターネット企業を経て、グローバルプロフェッショナルファームにてAIおよび先端技術を活用したDX、企業支援、産業支援に従事。東北大学 特任教授、東京大学 協創プラットフォーム開発 顧問、日本ディープラーニング協会 顧問。著訳書に、『ウェブ大変化 パワーシフトの始まり』(近代セールス社)、『グローバルAI活用企業動向調査 第5版』(共訳、デロイト トーマツ社)、『信頼できるAIへのアプローチ』(監訳、共立出版)など多数。